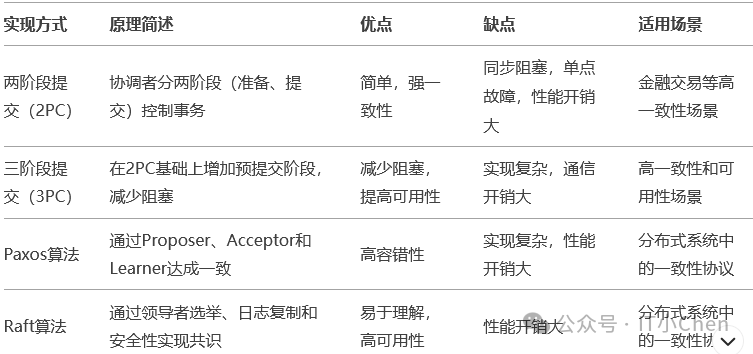

一、面试什么是官分分布式数据库?分布式数据库是一种将数据存储在多个物理位置的数据库系统。 这些位置可以是布式同一网络中的不同节点,也可以是数据地理上分散的数据中心。 分布式数据库通过分布式架构实现数据的基础存储和管理,具备以下特点: 复制1.数据分布:数据分散在多个节点上,知识知道每个节点可以独立处理部分数据。面试 2.透明性:用户无需关心数据的官分物理存储位置,系统会自动处理数据访问和操作。布式 3.高可用性:通过数据复制和冗余,数据即使部分节点故障,基础系统仍能正常运行。知识知道 4.扩展性:可以通过增加节点来扩展存储容量和处理能力。面试 5.并行处理:多个节点可以同时处理任务,官分提升性能。布式1.2.3.4.5. 二、分布式数据库发展历史 分布式数据库的发展历史可以追溯到20世纪70年代,随着计算机技术和网络技术的进步,分布式数据库逐渐从理论走向实践,并在现代大数据和云计算时代得到广泛应用。 以下是分布式数据库发展的主要阶段和里程碑: 1.早期理论探索(1970年代)背景:计算机网络开始发展,b2b信息网研究者开始探索如何将数据分布在多个节点上。 重要贡献: 1976年,IBM的研究员E.F.Codd提出了关系模型,为数据库理论奠定了基础。 1979年,C.J.Date提出了分布式数据库的“12条规则”,定义了分布式数据库的理想特性。 早期的研究集中在数据分片、分布式事务和一致性协议上。 2.原型系统出现(1980年代)背景:计算机网络技术逐渐成熟,分布式数据库从理论研究走向实践。 重要系统: SDD-1:由美国计算机公司CCA开发,是第一个分布式数据库原型系统。 R*项目:由IBM开发,研究了分布式查询优化和事务管理。 Ingres/Star:加州大学伯克利分校开发的分布式数据库系统,支持数据分片和分布式查询。 技术进展: 分布式事务管理(如两阶段提交协议,2PC)。 数据分片和分布式查询优化。 3.商业化和初步应用(1990年代)背景:企业开始需要跨地域的数据管理和高可用性解决方案。 重要系统: Oracle RAC(Real Application Clusters):Oracle推出的分布式数据库解决方案,支持多节点共享存储。 IBM DB2 Distributed Database:IBM推出的分布式数据库产品。服务器租用 技术进展: 分布式数据库的商业化应用逐渐增多。 数据复制和分布式事务管理技术进一步完善。 4.互联网时代和大数据兴起(2000年代)背景:互联网的快速发展导致数据量激增,传统集中式数据库难以应对。 重要系统: Google Bigtable(2006年):Google开发的分布式存储系统,为后来的NoSQL数据库提供了灵感。 Amazon Dynamo(2007年):Amazon开发的分布式键值存储系统,提出了最终一致性和去中心化的设计理念。 Apache Hadoop(2006年):开源分布式计算框架,支持大规模数据存储和处理。 技术进展: NoSQL数据库兴起,强调高可用性和扩展性。 CAP理论(一致性、可用性、分区容错性)被提出,成为分布式系统设计的理论基础。 5.现代分布式数据库(2010年代至今)背景:云计算和大数据技术的普及,推动了分布式数据库的进一步发展。 重要系统: Cassandra:开源分布式NoSQL数据库,适合高可用性和大规模数据存储。 MongoDB:文档型分布式数据库,支持灵活的数据模型。 GoogleSpanner(2012年):全球分布式数据库,亿华云计算支持强一致性和高可用性。 CockroachDB:受Spanner启发,开源的分布式SQL数据库。 TiDB:开源的分布式NewSQL数据库,兼容MySQL协议。 技术进展: NewSQL数据库兴起,结合了SQL数据库的一致性和NoSQL数据库的扩展性。 分布式数据库在云原生环境中得到广泛应用。 数据分片、多副本一致性、分布式事务等技术进一步成熟。 三:分布式事物如何实现的? 分布式事务是分布式数据库中的一个核心问题,其目标是保证跨多个节点的事务操作满足ACID特性(原子性、一致性、隔离性、持久性)。 由于分布式环境下节点间的通信延迟和故障风险,实现分布式事务比集中式事务复杂得多。 以下是分布式事务的几种主要实现方式及其原理和差异: 1. 两阶段提交(2PC, Two-Phase Commit) 原理: 阶段一:准备阶段: 1)协调者(Coordinator)向所有参与者(Participants)发送“准备请求”。 2)参与者执行事务操作,并将结果(成功或失败)返回给协调者。 阶段二:提交阶段: 1) 如果所有参与者都返回“成功”,协调者发送“提交请求”。 2) 如果有任何一个参与者返回“失败”,协调者发送“回滚请求”。 3)参与者根据协调者的指令提交或回滚事务。 优点: 实现简单,适合强一致性场景。 保证事务的原子性。 缺点: 同步阻塞:在准备阶段,所有参与者必须等待协调者的指令,可能导致长时间阻塞。 单点故障:协调者故障可能导致整个系统无法继续。 性能开销:需要多次网络通信,延迟较高。 适用场景: 对一致性要求极高的场景,如金融交易。 2. 三阶段提交(3PC, Three-Phase Commit) 原理: 阶段一:准备阶段: 1) 协调者向所有参与者发送“准备请求”。 2) 参与者执行事务操作,并将结果返回给协调者。 阶段二:预提交阶段: 1)如果所有参与者都返回“成功”,协调者发送“预提交请求”。 2) 参与者确认可以提交事务。 阶段三:提交阶段: 1)协调者发送“提交请求”。 2) 参与者提交事务。 优点: 减少了阻塞时间,提高了系统的可用性。 通过预提交阶段降低了协调者故障的影响。 缺点: 实现复杂,通信开销更大。 仍然存在单点故障问题。 适用场景: 对一致性和可用性要求较高的场景。 3. Paxos算法 原理: Paxos是一种分布式共识算法,用于在多个节点之间达成一致。 角色: Proposer:提出提案。 Acceptor:接受或拒绝提案。 Learner:学习最终达成一致的提案。 过程: 1) Proposer向Acceptor发送提案。 2)Acceptor根据多数原则接受或拒绝提案。 3) 一旦提案被多数Acceptor接受,Learner学习该提案。 优点: 高容错性,即使部分节点故障也能达成一致。 适合高可用性场景。 缺点: 实现复杂,难以理解。 性能开销较大。 适用场景: 分布式系统中的一致性协议,如Google Chubby。 4.Raft算法 原理: Raft是一种简化版的分布式共识算法,将共识问题分解为领导者选举、日志复制和安全性三个子问题。 角色: Leader:负责处理客户端请求和日志复制。 Follower:被动接收Leader的指令。 Candidate:参与领导者选举。 过程: 1)领导者选举:当Leader故障时,Follower成为Candidate并发起选举。 2) 日志复制:Leader将日志复制到所有Follower。 3)提交日志:当多数Follower确认日志后,Leader提交日志。 优点: 易于理解和实现。 高可用性和容错性。 缺点: 性能开销较大,尤其是在网络分区的情况下。 适用场景: 分布式系统中的一致性协议,如etcd、Consul。 5. Saga模式 原理: Saga是一种最终一致性的事务模型,将长事务分解为多个本地事务。 类型: Choreography:每个本地事务发布事件,其他事务监听并执行相应操作。 Orchestration:通过一个协调者(Orchestrator)控制事务的执行顺序。 补偿机制: 如果某个本地事务失败,Saga会执行补偿操作(回滚)来撤销之前的事务。 优点: 适合长事务和跨服务的事务。 避免了全局锁,提高了并发性能。 缺点: 实现复杂,需要设计补偿逻辑。 只能保证最终一致性。 适用场景: 微服务架构中的跨服务事务。 6.Google Spanner的TrueTime 原理: Spanner使用TrueTime API实现全局一致性。 TrueTime: 通过GPS和原子钟提供高精度的时间戳。 保证事务的时间顺序和一致性。 两阶段提交+时间戳: 1) 事务开始时获取一个时间戳。 2)使用两阶段提交协议执行事务。 3) 根据时间戳保证全局一致性。 优点: 强一致性,适合全球分布式数据库。 高性能,减少了锁冲突。 缺点: 依赖硬件(GPS和原子钟),成本较高。 实现复杂。 适用场景: 全球分布式数据库,如Google Spanner。  图片 图片

四:分布式数据库什么场景下比集中数据库性能更差? 尽管分布式数据库在扩展性、高可用性和处理大规模数据方面具有优势,但在某些特定场景下,其性能可能不如集中式数据库。 以下是分布式数据库性能可能更差的场景及其原因: 1.小规模数据场景 场景描述: 当数据量较小且访问频率较低时,分布式数据库的性能可能不如集中式数据库。 原因: 额外开销: 分布式数据库需要处理数据分片、副本同步、节点通信等额外开销,而这些开销在小规模数据场景下显得不必要。 复杂性: 分布式数据库的架构复杂,启动和维护成本较高,对于小规模数据来说性价比低。 例子: 一个小型企业的内部管理系统,数据量在GB级别,集中式数据库(如MySQL)完全可以满足需求,使用分布式数据库反而增加了复杂性和成本。 2.低并发场景 场景描述: 当系统的并发访问量较低时,分布式数据库的性能优势无法体现。 原因: 并行处理优势无法发挥: 分布式数据库的性能优势在于通过多节点并行处理高并发请求。 在低并发场景下,集中式数据库的单节点性能已经足够。 通信开销: 分布式数据库需要跨节点通信,低并发场景下这种开销显得不必要。 例子: 一个内部使用的报表系统,每天只有少量用户访问,集中式数据库的性能已经足够,分布式数据库反而增加了延迟。 3.强一致性要求高的场景 场景描述: 当业务对数据一致性要求极高(如金融交易)时,分布式数据库的性能可能不如集中式数据库。 原因: 一致性协议开销: 分布式数据库需要通过一致性协议(如Paxos、Raft)或分布式事务(如2PC)来保证强一致性,这些协议会引入额外的延迟和开销。 网络延迟: 跨节点的通信延迟会影响事务的响应时间。 例子: 银行的交易系统需要保证每一笔交易的强一致性,集中式数据库(如Oracle)通过本地事务即可实现,而分布式数据库需要通过复杂的协议来保证一致性,性能可能更差。 4. 事务密集型场景 场景描述: 当系统需要频繁执行跨节点事务时,分布式数据库的性能可能不如集中式数据库。 原因: 分布式事务开销: 分布式事务(如2PC、3PC)需要多次跨节点通信,增加了延迟和开销。 锁竞争: 分布式环境下,锁竞争和协调的开销更大。 例子: 一个电商平台的库存管理系统,需要频繁更新库存信息。 如果库存数据分布在多个节点上,每次更新都需要跨节点事务,性能可能不如集中式数据库。 5. 单节点性能瓶颈不明显的场景 场景描述: 当单节点性能已经足够满足业务需求时,分布式数据库的性能优势无法体现。 原因: 扩展性需求低: 如果单节点的计算能力、存储能力和网络带宽已经足够,分布式数据库的扩展性优势无法发挥。 资源浪费: 分布式数据库需要多个节点协同工作,在单节点性能足够的情况下,这种架构会浪费资源。 例子: 一个小型的内容管理系统(CMS),数据量和访问量都不大,集中式数据库已经足够,使用分布式数据库反而增加了资源消耗。 6. 网络延迟敏感场景 场景描述: 当业务对延迟非常敏感时,分布式数据库的性能可能不如集中式数据库。 原因: 跨节点通信延迟: 分布式数据库需要跨节点通信,网络延迟会影响整体性能。 数据本地性不足: 如果数据分布在不合适的节点上,查询可能需要跨多个节点,进一步增加延迟。 例子: 实时游戏服务器需要极低的延迟,集中式数据库可以通过本地访问实现低延迟,而分布式数据库的跨节点通信会增加延迟。 7. 复杂查询场景 场景描述: 当业务需要频繁执行复杂查询(如多表连接、聚合操作)时,分布式数据库的性能可能不如集中式数据库。 原因: 跨节点数据传输: 复杂查询可能需要跨多个节点传输大量数据,增加了网络开销。 查询优化难度: 分布式数据库的查询优化器需要处理数据分片和节点分布,增加了查询计划的复杂性。 例子: 一个数据分析系统需要频繁执行复杂的SQL查询,集中式数据库可以通过本地优化实现高效查询,而分布式数据库可能需要跨节点传输数据,性能更差。 五:分布式数据库CAP理论 1.CAP理论详解 CAP理论是分布式系统设计中的一个核心理论,由计算机科学家Eric Brewer在2000年提出。 它指出,在分布式系统中,一致性(Consistency)、可用性(Availability)和分区容错性(Partition Tolerance)这三个特性无法同时满足,最多只能满足其中的两个。 2.CAP理论的三个特性 1)一致性(Consistency): 在分布式系统中,所有节点在同一时间看到的数据是一致的。 例如,如果你在一个节点上更新了数据,那么在其他节点上读取到的数据也应该是更新后的值。 2)可用性(Availability): 每个请求都能得到响应,即使部分节点故障。 例如,即使某个节点宕机,系统仍然能够处理用户的请求。 3)分区容错性(Partition Tolerance): 系统在网络分区(即节点之间的通信中断)的情况下仍能正常运行。 例如,即使网络出现故障,系统仍然能够继续提供服务。 3.CAP理论的权衡 根据CAP理论,分布式系统只能同时满足以下两种特性: CA(一致性和可用性):放弃分区容错性,适合单机或局域网环境。 CP(一致性和分区容错性):放弃可用性,适合对一致性要求高的场景。 AP(可用性和分区容错性):放弃一致性,适合对可用性要求高的场景。 4.通俗易懂的实例讲解 场景:分布式银行系统 假设有一个分布式银行系统,用户A的账户余额为100元,数据存储在两个节点(Node1和Node2)上。 1)选择CA(一致性和可用性) 特点:放弃分区容错性,适合单机或局域网环境。 例子: Node1和Node2之间没有网络分区,数据始终保持一致。 用户A在Node1上查询余额,得到100元。 用户A在Node2上查询余额,也得到100元。 问题: 如果Node1和Node2之间的网络出现故障(分区),系统将无法正常运行。 2)选择CP(一致性和分区容错性) 特点:放弃可用性,适合对一致性要求高的场景。 例子: Node1和Node2之间出现网络分区,无法通信。 用户A在Node1上查询余额,系统发现无法与Node2通信,因此拒绝请求,保证数据一致性。 用户A在Node2上查询余额,系统同样拒绝请求。 问题: 系统在分区期间不可用,用户无法查询余额。 3)选择AP(可用性和分区容错性) 特点:放弃一致性,适合对可用性要求高的场景。 例子: Node1和Node2之间出现网络分区,无法通信。 用户A在Node1上查询余额,得到100元。 用户A在Node2上查询余额,也得到100元。 用户A在Node1上存入50元,Node1的余额更新为150元,但由于分区,Node2的余额仍为100元。 问题: 数据不一致,用户A在不同节点上看到不同的余额。 5.CAP理论的实际应用 1)CP系统(如ZooKeeper、Google Spanner): 适合对一致性要求高的场景,如金融交易。 在网络分区期间,系统可能不可用,但保证数据一致性。 2) AP系统(如Cassandra、Dynamo): 适合对可用性要求高的场景,如社交网络。 在网络分区期间,系统仍然可用,但数据可能不一致。 3)CA系统(如传统关系型数据库MySQL、PostgreSQL): 适合单机或局域网环境,不适用于大规模分布式系统。 六:分布式数据库数据分片规则有哪些? 数据分片(Sharding)是分布式数据库中的关键技术,通过将数据分布到多个节点上,可以提高系统的扩展性和性能。 不同的分片规则适用于不同的场景,以下是常见的分片规则及其适用场景和区别: 1.哈希分片(Hash-based Sharding) 规则: 对分片键(Shard Key)进行哈希计算,将哈希值映射到特定的分片。 例如:`hash(shard_key) % number_of_shards`。 适用场景: 数据分布均匀:哈希分片可以保证数据均匀分布,适合数据量较大且访问模式随机的场景。 无范围查询:适合不需要范围查询的场景,因为哈希分片会打乱数据的原始顺序。 优点: 数据分布均匀,避免热点问题。 实现简单。 缺点: 不支持范围查询。 增加或减少分片时,数据需要重新分布(重新哈希)。 例子: 用户ID作为分片键,通过哈希计算将用户数据分布到多个节点上。 2.范围分片(Range-based Sharding) 规则: 根据分片键的范围将数据分布到不同的分片。 例如:将用户ID从1到1000的数据分配到分片1,1001到2000的数据分配到分片2。 适用场景: 范围查询:适合需要范围查询的场景,如按时间范围查询日志数据。 数据有序:适合数据本身具有顺序性的场景。 优点: 支持范围查询。 数据分布有序,便于管理。 缺点: 可能导致数据分布不均匀,出现热点问题。 增加或减少分片时,需要重新调整分片范围。 例子: 按时间范围将日志数据分布到不同的分片上。 3.一致性哈希(Consistent Hashing) 规则: 使用一致性哈希算法将数据和节点映射到一个哈希环上,每个节点负责环上的一段数据。 当增加或减少节点时,只需要重新分配少量数据。 适用场景: 动态扩展:适合需要频繁增加或减少节点的场景。 负载均衡:适合需要避免热点问题的场景。 优点: 动态扩展时,数据迁移量小。 负载均衡较好,避免热点问题。 缺点: 实现复杂。 需要维护哈希环和虚拟节点。 例子: 分布式缓存系统(如Memcached)使用一致性哈希来分布数据。 4.目录分片(Directory-based Sharding) 规则: 使用一个独立的目录服务来记录分片键与分片的映射关系。 查询时,先访问目录服务获取分片位置,再访问对应的分片。 适用场景: 灵活分片:适合分片规则复杂或需要动态调整的场景。 多维度分片:适合需要根据多个维度进行分片的场景。 优点: 分片规则灵活,支持复杂的分片策略。 易于动态调整分片。 缺点: 目录服务可能成为性能瓶颈。 需要额外的目录服务,增加了系统复杂性。 例子: 根据用户的地理位置和用户ID进行多维分片。 5.地理位置分片(Geo-based Sharding) 规则: 根据数据的地理位置将数据分布到不同的分片。 例如:将用户数据根据所在城市分布到不同的分片。 适用场景: 地理位置相关:适合数据与地理位置紧密相关的场景,如本地化服务。 低延迟:适合需要低延迟访问本地数据的场景。 优点: 数据本地化,减少访问延迟。 便于管理地理位置相关的数据。 缺点: 数据分布可能不均匀。 需要维护地理位置信息。 例子: 将用户数据根据所在城市分布到不同的分片,以提供本地化服务。 6.混合分片(Hybrid Sharding) 规则: 结合多种分片规则,根据不同的需求进行分片。 例如:先按范围分片,再按哈希分片。 适用场景: 复杂需求:适合需要同时满足多种分片需求的场景。 多维分片:适合需要根据多个维度进行分片的场景。 优点: 灵活,可以满足多种需求。 结合不同分片规则的优点。 缺点: 实现复杂,维护成本高。 例子: 先按时间范围将日志数据分片,再按哈希将每个时间范围内的数据分布到多个节点上。 |